Jak powstał nowy wykaz czasopism naukowych

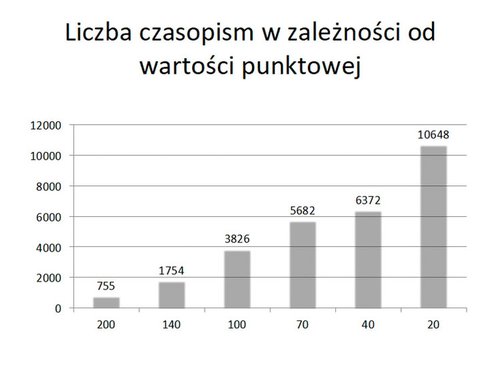

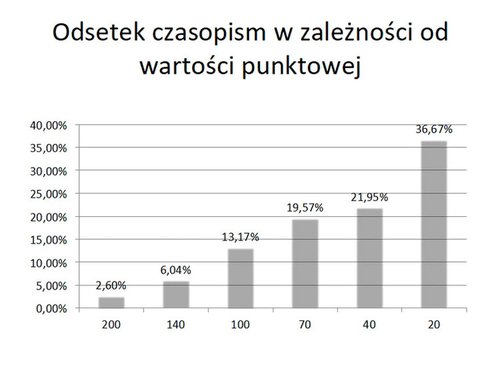

Długo wyczekiwany nowy wykaz czasopism naukowych wraz z przypisanymi im punktami pojawił się na stronie MNiSW po południu 31 sierpnia 2019 r. Zawiera ponad 29 tysięcy tytułów czasopism, co wraz z punktowanymi materiałami konferencyjnymi (1639 pozycji, głównie z informatyki) daje liczbę 30.676 tytułów, którym przypisano od 20 do 200 punktów. Liczba czasopism jest ujemnie skorelowana z ich wagą punktową (zob. wykresy): najmniej jest tych za 200 punktów, a najwięcej tych za 20 punktów. Warto przypomnieć, że tak zwana lista A, obejmująca czasopisma notowane w JCR, zawierała „tylko” niecałe 12 tys. tytułów, a listy B i C (częściowo się pokrywające) obejmowały około czterech tysięcy pozycji. Obecna lista jest zatem mniej więcej dwukrotnie obszerniejsza niż tamte wykazy razem wzięte. Warto mieć to na uwadze, szczególnie w kontekście poglądów głoszonych przez niektórych pracowników nauki w Polsce, że „nie mają gdzie publikować”, w związku z czym muszą założyć nowe czasopismo uczelniane lub wydziałowe.

Radykalne zwiększenie liczby punktowanych czasopism wynikało z przyjętej zasady, że podstawą wykazu ma być nie JCR, lecz również baza Scopus, a także inne bazy: Science Citation Index Expanded, Social Sciences Citation Index, Arts & Humanities Citation Index oraz Emerging Sources Citation Index. Scopus jest bazą bardzo obszerną, ponadto nieograniczoną do języka angielskiego. Dlatego w nowym wykazie znalazły się czasopisma publikujące po francusku, niemiecku, hiszpańsku i oczywiście po polsku, co było postulowane przez niektórych przedstawicieli środowiska naukowego, przede wszystkim humanistów. Najwyżej rangowane nieanglojęzyczne czasopisma uzyskały maksymalną możliwą liczbę 200 punktów.

Obecny wykaz jest dokumentem ministerialnym w tym znaczeniu, że minister go autoryzował jako jedno z ważnych narzędzi oceny jakości działalności naukowej, ale również dlatego, że dwa akty prawne – Ustawa 2.0 a przede wszystkim rozporządzenie ministra nauki i szkolnictwa wyższego z 7 listopada 2018 – w ogromnej większości zdeterminowały liczbę punktów przypisanych czasopismom. Tak więc punkty nie były ustalane ręcznie, lecz wynikały z zasad zawartych w aktach prawnych.

Czterdzieści cztery zespoły

Proces ustalania punktów toczył się w kilku etapach. Najpierw przypisano tytuły dyscyplinom naukowym. Był to proces dość żywiołowy, słabo moderowany przez ministerstwo, dlatego efekty w wielu przypadkach wzbudziły zrozumiały sprzeciw, a nawet oburzenie części środowiska (przykładem „Studia Logica” przypisane filozofii, ale i historii, albo „Developmental Psychology”, które oprócz prac z psychologii rozwojowej rzekomo publikuje też prace historyków). Proces przypisania czasopism do dyscyplin początkowo był motywowany zamiarem, aby w ocenie jakości działalności naukowej uwzględnić głównie dorobek w danej dyscyplinie. Z tego zamiaru ustawodawca ostatecznie się wycofał i obecnie obowiązuje zasada, że dorobek poddany ocenie nie będzie uwarunkowany przynależnością czasopisma do jakiejkolwiek dyscypliny. Jednak przypisanie czasopism do dyscyplin miało swoje konsekwencje w drugim etapie prac nad wykazem, kiedy działały 44 zespoły eksperckie, po jednym w każdej dyscyplinie. Minister powołał te zespoły w roku 2018, dając im bardzo istotne zadania do wykonania.

Po pierwsze, zespoły mogły dodać do swojej dyscypliny nowe czasopisma lub odjąć te, które do danej dyscypliny nie należą. Niestety brak jednolitych kryteriów spowodował, że niektóre zespoły tworzyły listy bardzo szerokie, obejmujące tytuły luźno powiązane z reprezentowanymi przez nie dyscyplinami. Brak klarownych zasad, którym byłoby podporządkowane to działanie, był niewątpliwie błędem, który należałoby w przyszłości wyeliminować.

Po drugie, zespoły ustalały, który wskaźnik wpływu będzie decydujący w ustalaniu rankingu czasopism. Do wyboru były następujące wskaźniki: Source Normalized Impact per Paper (SNIP), CiteScore, Scimago Journal Rank (SJR), Journal Impact Factor (IF), Article Influence oraz Category Normalized Citation Impact. Ustawodawca przesądził, że nie będzie narzucony wszystkim jeden wskaźnik wpływu. Zespoły eksperckie w 44 dyscyplinach miały w tej sprawie głos decydujący. Wybrany wskaźnik wpływu skutkował wstępnym ustaleniem pozycji czasopisma i przypisaniem mu wartości punktowej. Wartość ta wynikała z pozycji centylowej czasopisma w rankingu, a więc zależała od liczby cytowań artykułów publikowanych w danym czasopiśmie, z tym że miara owej cytowalności była wybrana przez zespół ekspercki.

Po trzecie, zespoły eksperckie mogły podwyższać lub obniżać wartość punktową czasopisma, jeśli uznały, że w danej dyscyplinie waży ono więcej lub mniej, niżby to wynikało z mechanicznego stosowania wskaźnika wpływu. Zmiany tego rodzaju nie mogły jednak przekraczać dwóch progów punktowych. Na przykład zespół mógł podnieść wyjściową wartość 70 punktów do 100 lub 140, ale nie do 200. Mógł również obniżyć wyjściową wartość, np. ze 140, do 100 lub 70. To jeden z nielicznych elementów procesu oceny, który polegał na uznaniowej, „ręcznej” decyzji zespołu ekspertów, ale bardzo brzemienny w skutkach. Zmiana punktacji dotyczyła bowiem także czasopism, które znalazły się na liście, bo uzyskały dofinansowanie ministerstwa (tzw. Lista Wsparcia Czasopism Naukowych obejmująca ponad 500 polskich czasopism) oraz te, które zostały włączone z listy ERIH+ (nauki humanistyczne i społeczne), o czym poniżej.

Ewidentny błąd systemowy

Rezygnacja z jednolitego wskaźnika wpływu oraz decyzje zespołów o podwyższeniu lub obniżeniu wartości punktowej czasopism skutkowały tym, że owa wartość mogła być różna w zależności od dyscypliny. Tymczasem ocena jakości działalności naukowej wymaga jednej wartości dla jednego tytułu. Zgodnie z rozporządzeniem owe rozbieżności likwidowano automatycznie, obliczając średnią arytmetyczną i zaokrąglając wynik. Na przykład jeśli dany tytuł otrzymał od trzech zespołów dyscyplinowych wartości 140, 70 i 70, jego ostateczna wartość wyniosła 100 (140 + 70 + 70 = 280, dzielone przez 3 = 93,3, co w przybliżeniu daje 100). Ale jeśli włączyły się w to dwa inne zespoły, które również dały po 70, ostateczny wynik spadał do 70. Nie ma w tym nic groźnego, jeśli czasopismo rzeczywiście publikuje teksty nadsyłane przez przedstawicieli każdej z tych pięciu dyscyplin, przy czym cztery dyscypliny uznają je za przeciętne. Niestety zdarzało się, że niektóre zespoły ekspertów, stwierdzając, że dane czasopismo nie publikuje tekstów z ich dyscypliny, obniżały jego wartość punktową (zamiast skreślić je z dyscypliny!). Po obliczeniu średniej okazywało się, że bardzo dobre czasopismo otrzymywało niezasłużenie niski wynik, ponieważ wcześniej przypisano je do przypadkowych dyscyplin (bez czytelnego powodu), a następnie obniżono mu punkty na podstawie oczywistego faktu, że do tych dyscyplin nie należy. Nie było podstaw formalnych, aby naprawić skutki takiej niezrozumiałej postawy niektórych zespołów, chyba że rozbieżność ocen była drastyczna (przekraczała dwa progi punktowe). Ten ewidentny błąd systemowy powinien być naprawiony w kolejnym podejściu do tworzenia wykazu czasopism.

Procedura opisana powyżej wyjaśnia 88% ostatecznego kształtu wykazu. W przypadku pozostałych 12% (ok. 3.700 tytułów) włączyła się Komisja Ewaluacji Nauki, powołana przez ministra 1 marca 2019 r. Warto mieć to na uwadze, ponieważ krytyka, a niekiedy oburzenie części środowiska kontestującego ostateczny kształt wykazu, kierowane są głównie pod adresem KEN. Tymczasem KEN miała coś do powiedzenia tylko w przypadku owych 12% i robiła to w ramach procedur wynikających z odpowiednich przepisów i zarządzeń wydanych przez ministerstwo.

Po pierwsze, KEN została zobowiązana do zaproponowania ostatecznej wartości punktowej czasopisma, gdy rozbieżność ocen ustalonych przez różne zespoły dyscyplinowe była bardzo duża, tj. przekraczała dwa progi punktowe (np. 140, 40, 70). Było tak w przypadku ok. 700 tytułów. Komisja uchwaliła, że w takiej sytuacji będzie się kierować średnią ważoną, przypisując 75% wpływu tzw. dyscyplinie wiodącej, a tylko 25% wpływu wszystkim pozostałym dyscyplinom, których eksperci oceniali dany tytuł. Najpierw konsensualnie ustalono, co będzie uważane za dyscyplinę wiodącą, a następnie ustalono ostateczną wartość punktową według wzoru na średnią ważoną. W ten sposób, nie ignorując stanowiska żadnego z 44 zespołów eksperckich, przyznano głos decydujący temu zespołowi, który reprezentował dyscyplinę wiodącą. Na przykład czasopismo par excellence psychologiczne było oceniane przez psychologów, historyków, medyków oraz architektów i urbanistów, ale stanowisko zespołu psychologicznego uzyskało 75% wpływu na ostateczny wynik. Zdaniem KEN, ustalenie dyscypliny wiodącej powinno zostać w najbliższym czasie zastosowane również wobec czasopism, w przypadku których rozbieżność ocen wynosi dwa progi punktowe.

Brak jednolitości postępowania

Po drugie, KEN musiała ustalić wartość punktową czasopism spoza baz JCR i Scopus, które ostatecznie też znalazły się w wykazie. Należały one do dwóch kategorii: (1) te, które przystąpiły do ministerialnego programu wsparcia czasopism naukowych (WCN, ponad 500 przypadków) oraz (2) te, które znajdują się na liście ERIH+, ale nie w bazie JCR, Scopus lub innych bazach stanowiących podstawę wykazu. Pierwsze znalazły się w wykazie automatycznie z wyjściową wartością punktową 20 (co wynika z rozporządzenia), jednak wartość ta mogła być podwyższona maksymalnie o dwa progi, czyli do 40 lub nawet 70 punktów. Propozycje podwyższenia punktów niektórym czasopismom z programu WCN mogły być zgłaszane przez zespoły dyscyplinowe – było to ich kolejne uprawnienie, z którego niektóre bardzo chętnie skorzystały, a inne całkowicie z tego zrezygnowały. W przypadku także tej procedury ujawnił się głęboki brak jednolitości postępowania zespołów eksperckich. KEN musiała podjąć decyzję, czy podtrzymać te propozycje (ok. 2.000 tytułów, w tym pozycje z ERIH+, zob. następny akapit). Kierowano się tutaj oceną rzeczywistej pozycji czasopisma na tle całej nauki. Starannie badano każdą propozycję, analizując czasopismo i zawarte w nim teksty od strony formalnej i treściowej. Tylko część propozycji zespołów eksperckich podtrzymano, uznając je za wystarczająco umotywowane.

Czasopisma z drugiej kategorii (ERIH+) mogły wejść do wykazu, ale nie musiały. Warto przypomnieć w tym miejscu, że lista ERIH+ powstała w wyniku przejęcia w roku 2014 listy ERIH (European Reference Index for the Humanities) przez Norwegian Centre for Research (NSD) od European Science Foundation (ESF), czyli Europejskiej Fundacji Nauki. W roku 2007 oraz 2011 ESF opublikowała dwa wykazy list czasopism humanistycznych o zasięgu krajowym i międzynarodowym, korzystając z opinii ekspertów. Tytuły te w roku 2014 włączono automatycznie do listy ERIH+, po czym każdy kolejny tytuł spełniający kryteria formalne był automatycznie dopisywany do tej listy poprzez zgłoszenie do ESF. Od samego początku lista ERIH i jej spadkobierca nie miały charakteru bibliometrycznego, a w przypadku listy ERIH+ włączone do niej czasopisma nie były poddawane ocenie eksperckiej. Stąd KEN, odnosząc się do propozycji zespołów dyscyplinowych, zachowała szczególną ostrożność w przyznawaniu punktów czasopismom z listy ERIH+.

Propozycje włączenia niektórych tytułów, wraz z przypisanymi im wartościami punktowymi (20, 40 lub 70), były formułowane przez zespoły eksperckie (ich kolejne uprawnienie), a weryfikowane przez KEN. Decyzje tego rodzaju dotyczyły około tysiąca czasopism, głównie krajowych, ale również pochodzących z obszaru Europy Środkowo-Wschodniej, Bałkanów, Turcji, Indii lub Ameryki Łacińskiej. Prawie wszystkie dotyczyły dyscyplin humanistycznych (głównie historii) i niektórych społecznych (prawo). Również w tym przypadku starannie badano każdy tytuł, po czym w niektórych przypadkach podtrzymano w całości propozycję zespołu (włączenie czasopisma i podniesienie mu punktacji), w części przypadków podtrzymano decyzję o włączeniu, ale nie o podwyższeniu punktacji, w pozostałych – odrzucono propozycje zespołów.

Nierzetelność uzasadnień

To właśnie decyzje dotyczące czasopism z programu WCN i z ERIH+ wzbudziły żywe reakcje, niekiedy bardzo krytyczne. Warto więc poświęcić tej sprawie nieco uwagi, mimo że problem dotyczy zaledwie kilku procent wykazu w jego ostatecznej postaci (KEN podtrzymała propozycje zespołów w 85% przypadków. Pozostałe przypadki to 15% z ogólnej liczby 3.000 (2.000 – zmiana punktacji, 1.000 – awans z ERIH+), czyli ok. 450 przypadków, a więc niecałe 1,5% całości wykazu). Formułowane są zarzuty, jakoby KEN radykalnie zmieniła propozycje ekspertów, co nie odpowiada prawdziwemu stanowi rzeczy. Stawiane są pytania, na jakiej podstawie to uczyniła, skoro propozycje formułowali eksperci.

Przede wszystkim zespoły ekspertów, podobnie jak sama KEN, to ciała doradcze, a nie decyzyjne. Główną przyczyną zmiany propozycji wypracowanych przez zespoły była stwierdzona w wielu przypadkach nierzetelność uzasadnień. Rozporządzenie ministra daje zespołowi prawo zmiany punktacji, ale to „wymaga szczegółowego uzasadnienia” (§ 13.2). Wiele uzasadnień było rzeczywiście szczegółowych i wnikliwych, i takie zawsze były przez KEN akceptowane. Były też niestety uzasadnienia powierzchowne, zdawkowe, mechanicznie powielane z tytułu na tytuł, wreszcie zupełnie gołosłowne. Na przykład zespół proponował podwyższenie punktacji z 20 na 40 lub 70 pisząc tylko tyle, że czasopismo „ma istotny wpływ na rozwój dyscypliny”, a z analizy wynikało, że jest to czasopismo całkowicie lokalne i prawie niewidoczne nawet przez liberalny Google Scholar. Zdarzało się nawet, że „istotny wpływ na rozwój dyscypliny” – zdaniem zespołu – miały mieć czasopisma od dawna się nieukazujące. KEN nie mogła takich uzasadnień zaakceptować, stoi bowiem na stanowisku, że zrównywanie pozycji niezłych czasopism międzynarodowych ze „środkowej półki” (70 pkt.) z czasopismem, które jest dla nauki światowej zupełnie niedostrzegalne, miałoby nadzwyczaj szkodliwe konsekwencje dla tych środowisk naukowych. Część negatywnych opinii KEN-u nie zostało zaakceptowanych.

Nikła wartość poznawcza uzasadnień formułowanych przez niektóre zespoły skłoniła też KEN do odrzucenia pewnej liczby propozycji dotyczących awansowania czasopism z listy ERIH+. Pamiętajmy, że podczas prac nad Ustawą 2.0 najpierw dla takich czasopism w ogóle nie przewidywano miejsca w wykazie, potem planowano, że wejdą do wykazu wybrane pozycje z ERIH+, ale niepolskie, a ostatecznie ustawodawca postanowił dopuścić do wykazu również czasopisma wydawane w Polsce, których nie ma w żadnej bazie międzynarodowej z wyjątkiem ERIH+. Ta decyzja była odpowiedzią na postulaty przedstawicieli dyscyplin humanistycznych i niektórych społecznych, choć zdaniem zdecydowanej większości członków KEN prawdziwy interes tych dyscyplin nie polega na sztucznym podnoszeniu punktacji czasopismom, które na to nie zasługują, lecz na rzeczywistym przeorientowaniu się na publikowanie w obiegu globalnym. Niemniej furtkę otwarto, z czego skwapliwie skorzystały przede wszystkim dwa zespoły dyscyplinowe, załączając m.in. uzasadnienia o następującej treści: „użyteczne łamy dla publikacji przez polskich autorów”. Staranna analiza każdego przypadku, wraz z uzasadnieniem, skłoniła KEN do odrzucenia części tych propozycji. Zauważmy, że rozporządzenie zezwala na włączenie takiego czasopisma do wykazu, jeśli posiada „międzynarodową renomę i szczególny wpływ na rozwój danej dyscypliny naukowej” (§ 11.1). Ścisłe kierowanie się tą regułą nakazywałoby nie włączać do wykazu żadnego z tych czasopism, zatem KEN być może zasługuje na krytykę za podejście nadmiernie liberalne.

Krytyka dotyczy dołu listy

Pytanie, czy opublikowany wykaz jest optymalny, można uznać za retoryczne. Z pewnością nie, ale naszym zdaniem jest znacząco lepszy od poprzednich (lista A, B, C): obszerniejszy, bardziej zrównoważony, nieograniczony do języka angielskiego i niepodporządkowany ślepo wskaźnikowi IF. Niektóre wskazane powyżej błędy mogą być poprawione w kolejnym wykazie, czyli już za dwa lata. Inne, jak ustalenie dyscyplin wiodących, gdy rozbieżność punktacji wynosi dwa progi, mogą zostać wprowadzone szybciej.

Krytyka jest niezbędnym składnikiem tego typu przedsięwzięć. Pozwalamy sobie jednak zauważyć, co następuje. Po pierwsze, głosy krytyczne pochodzą przede wszystkim ze strony przedstawicieli niektórych (dalece nie wszystkich) dyscyplin humanistycznych i społecznych. Nie słychać wyrazów oburzenia przedstawicieli nauk ścisłych, technicznych i nauk o życiu. Ci, jeśli coś krytykują, to właśnie nadmierny ich zdaniem liberalizm KEN i ministerstwa. Środowisko naukowe w Polsce jest zróżnicowane i w swoich opiniach bardzo podzielone, również w tej sprawie. Po drugie, krytyka dotyczy dołu listy, czyli odnosi się do sytuacji, którą można obrazowo określić jako „70 minus”. A więc nie dyskutuje się, czy jakieś czasopismo powinno mieć 100 punktów, czy 140, czy może 70. Dyskutuje się, czy powinno było w ogóle znaleźć się w wykazie (5 punktów czy 20), a jeśli już tam się znalazło, to czy zasługuje na więcej niż 20 punktów (maksymalnie 70). Jednym słowem, oburzenie niektórych środowisk, naszym zdaniem przesadne, dotyczy tych propozycji KEN, a później decyzji MNiSW, które nawet gdyby były błędne, w minimalnym stopniu zaważą na ostatecznym kształcie oceny jakości działalności naukowej.

Postawmy bowiem na koniec pytanie, czemu właściwie ma służyć nowy wykaz. Jego podstawowy sens polega na dostarczeniu władzy państwowej narzędzia do oceny poziomu naukowego poszczególnych jednostek w dyscyplinach. Mówiąc wprost, minister potrzebuje wiedzieć, czy np. chemia na uczelni X jest lepsza czy gorsza od chemii na uczelni Y (lub w instytucie PAN). Od tej oceny ma zależeć kategoria uczelni w dyscyplinie, a zatem jej finansowanie z budżetu państwa, a także przywilej nadawania stopni naukowych. Natomiast punkty publikacyjne nie służą, a przynajmniej nie powinny służyć ocenie, czy np. chemik X jest lepszym uczonym od chemika Y. Ocena indywidualna – okresowa lub związana z awansami, stopniami, tytułem naukowym – powinna być oparta na całościowej, jakościowej i eksperckiej ewaluacji osobistego dorobku. Ze względu na skalę przedsięwzięcia takie podejście nie jest możliwe w ocenie jakości działalności naukowej.

Często niestety władze uczelni, a nawet recenzenci w postępowaniach awansowych, sumują punkty jako podstawę oceny indywidualnej. Jest to uproszczenie, które można uznać za niewłaściwe z gruntu. Punkty mogą stanowić początek procedury, ale nie mogą wyręczyć dziekana czy recenzenta w przewodzie od obowiązku wydania oceny wznoszącej się ponad to kryterium. Uczelnie powinny jak najszybciej odejść od kierowania się punktami w ocenie indywidualnej, choć zapewne rektorzy czy dziekani będą chcieli w ten czy inny sposób premiować „punktodajnych” pracowników. Jednak czym innym jest premia za szczególne osiągnięcia, a czym innym – naszym zdaniem szkodliwym – stosowanie wykazu czasopism punktowanych jako podstawowego narzędzia oceny pracownika. Jest to szczególnie groźne w przypadku oceny asystentów i doktorantów. Uzależnienie przyznania stypendium doktorskiego od liczby punktów uzyskanych w roku sprawozdawczym można uznać za rozwiązanie kuriozalne.

Groźne objawy punktozy

Środowisko naukowe w Polsce od dawna narzeka na „punktozę”. Posługiwanie się punktami w ocenie jakości działalności naukowej trudno jednak uznać za problem. System zobiektywizowanej oceny jednostek naukowych, nawet zgrubny, mało subtelny i „przesiewowy”, jest niezbędny. Wyobraźmy sobie, co by było, gdyby minister oceniał uczelnie i instytuty, opierając się na zupełnie arbitralnych przesłankach, ulegając różnym naciskom (indywidualnym, środowiskowym) lub na podstawie opinii powołanych przez siebie ekspertów. W Polsce się przyjęło, że minister posługuje się punktami, a Ustawa 2.0 utrwaliła ten stan rzeczy. Można teoretycznie pomyśleć o innym systemie, ale nie na gruncie tej ustawy. Punktoza staje się prawdziwie groźna, jeśli można dużą liczbą miernych publikacji zrównoważyć jedną pracę naprawdę wartościową, wymagającą znacznie większego wysiłku. Ta groźba ma być usunięta dzięki zasadzie, że każdy uczony może zgłosić do oceny tylko cztery publikacje na cztery lata, z czego uczelnia i tak usunie jedną. Inny groźny objaw punktozy to podporządkowanie własnych planów badawczych i publikacyjnych realnym lub spodziewanym decyzjom dotyczącym punktacji czasopism. Być może powinniśmy formować naszych uczniów i młodszych współpracowników w myśl reguły: pracuj najlepiej, jak umiesz i publikuj najwyżej, jak potrafisz, a system to zauważy. W dobrych jednostkach naukowych, a szczególnie w dobrze funkcjonujących zespołach, już teraz tak się pracuje. Nikt tam się nie kieruje punktami, bo i tak wie, gdzie warto wysłać tekst, aby był zauważony i miał wpływ na rozwój nauki. Punktów potrzebuje minister, aby wiedzieć, gdzie są takie jednostki naukowe i takie zespoły.

Warto także przypomnieć, że w toku ewaluacji jednostki oceniane są porównawczo, stąd zarzut, że w danej dyscyplinie jest mało czasopism punktowanych, odnosi się w równej mierze do wszystkich podmiotów. Sensem całej Reformy 2.0 jest dążenie do poprawy jakości badań naukowych i realizacja postulatu umiędzynarodowienia we wszystkich dziedzinach nauki i we wszystkich dyscyplinach, a nie tylko tych, w których stosuje się IF.

Dodaj komentarz

Komentarze