Hybrydowa miniaturyzacja

zdarza jej się odkryć.

Pierwszy medalowy sukces polskich olimpijczyków w Londynie starano się efektownie zobrazować, sięgając po… szpilkę. Mało tego – po jej główkę, w dodatku podzieloną jeszcze na cztery części. Tak niewielki miał być cel, do którego Sylwia Bogacka niemal idealnie strzelała z 10 metrów. Na chemikach, mierzących się na co dzień z rozmiarami nano, tego typu porównania nie robią większego wrażenia. Oni musieliby tę główkę szpilki podzielić na cztery jeszcze nie raz i nie dwa…

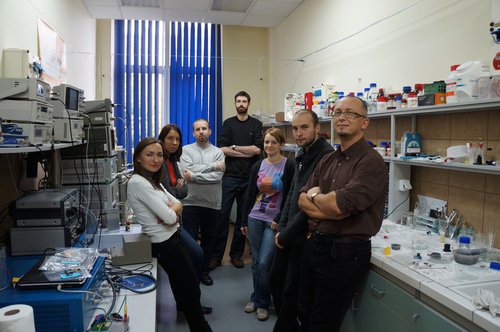

– Pracujemy na rozmiarach wielokrotnie mniejszych, rzędu 5-10 nanometrów, a przeciętny ludzki włos ma w przekroju około 80 tysięcy nanometrów – dr hab. Konrad Szaciłowski, zapraszając do Laboratorium Chemii Fizycznej i Elektrochemii Akademii Górniczo-Hutniczej w Krakowie, wskazuje aparaturę, która pozwoli ujrzeć te niedostrzegalne gołym okiem różnorodne struktury. I dodaje po chwili: – Sam rozmiar nie jest tu jednak najważniejszy.

Owszem, determinuje on w znacznym stopniu pewne ograniczenia, pojawiające się w postępującym w zawrotnym tempie procesie miniaturyzacji, ale to właśnie pokonanie tych barier, a nie samego rozmiaru, jest swoistym wyzwaniem. Ot, choćby takie zjawiska, których nie obserwuje się w skali makroskopowej, a tu – po zmniejszeniu obiektu – nagle zaczynają się pojawiać. Albo właściwości znanych materiałów, które w skali nano, ulegają zmianie…

Rewolucja nano

Tymczasem produkcja coraz mniejszych urządzeń wymusza stosowanie w nich jeszcze bardziej mikroskopijnych komponentów. Odkąd bowiem z górą pół wieku temu Richard Feynman w pracy There’s plenty of room at the bottom zapowiedział nadejście nanotechnologii, główna idea miniaturyzacji pozostaje niezmienna: zmniejszanie rozmiarów urządzeń elektronicznych ma jednocześnie zapewniać zwiększenie ich wydajności oraz przedłużenie czasu pracy. Sposobów dojścia do tego celu szuka się wszędzie, bo materiały stosowane dotychczas w układach elektronicznych, takich jak bramki logiczne, przełączniki optoelektroniczne czy sensory elektrochemiczne, wydają się być niewystarczające. Gwałtowne przyspieszenie nastąpiło zaraz po tym, gdy Amilra Prasanna de Silva po raz pierwszy zsyntetyzował molekularne bramki logiczne.

– W ślad za tym odkryciem postanowiliśmy do procesu przetwarzania informacji użyć materiałów hybrydowych, które byłyby odpowiedzią na wskazywane do tej pory ograniczenia w miniaturyzacji. Ich specyficzne właściwości spektroskopowe oraz fotoelektrochemiczne wynikają z połączenia trwałości i stabilności materiałów nieorganicznych, które są półprzewodnikami – co sprawia, że nadają się do zastosowania w urządzeniach elektronicznych, oraz różnorodnych właściwości cząsteczek organicznych, opartych w głównej mierze na węglu i wodorze – tłumaczy dr Konrad Szaciłowski.

Sama idea nie jest niczym nowym. Już w średniowieczu stosowano zaprawę murarską złożoną z wapna, piasku i jajek, i był to o wiele lepszy materiał hybrydowy niż połączenie wapna i piasku. Podobnie rzecz się ma z papierem. Do włókien celulozowych dodano tlenki metali, dzięki którym jest on odporny na światło, gładki i nadaje się do drukowania. Hybrydą jest też stosowana choćby w motoryzacji guma – polimer wypełniony cząstkami węgla. Takich przykładów można zresztą wymieniać bez liku.

– Innowacyjna w naszym pomyśle nie jest sama koncepcja, ale jej zastosowanie. Postanowiliśmy te „hybrydy” wykorzystać do przetwarzania informacji – opisuje dr Szaciłowski, wyliczając z jednej strony zastosowane przez jego zespół materiały nieorganiczne (dwutlenek tytanu, siarczek kadmu, selenek cynku), a z drugiej – cząsteczki organiczne, zarówno izolowane z organizmów żywych (witaminę B1, kwas foliowy czy kwas karminowy), jak i syntetyczne (fulereny, pochodne antrachinonu, polimery przewodzące).

Przełączenie fotoprądu

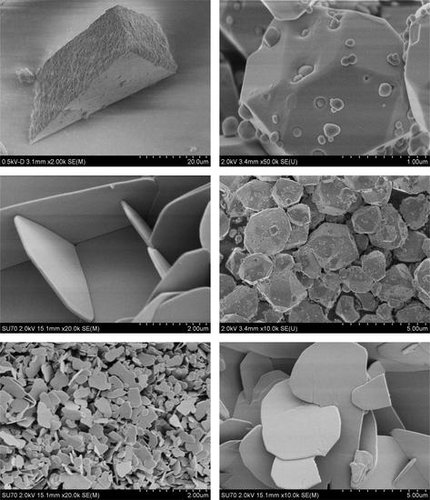

Zmodyfikowanie kryształu półprzewodnika związkiem organicznym dało zupełnie nowe właściwości. Kluczowe okazały się oddziaływania pomiędzy atomami na powierzchni półprzewodnika a tymi, które wiążą się z powierzchnią. To właśnie sposób oddziaływania determinuje właściwości danego materiału. Dzięki temu dziś można już zaprojektować materiał o pożądanych właściwościach. Ale jeszcze kilka lat temu było to nie do pomyślenia. Pierwsze materiały powstawały metodą prób i błędów.

– Kiedy zaczynaliśmy eksperymenty w 2004 roku, nie potrafiliśmy jeszcze zrozumieć właściwości nowych materiałów. Dopiero, gdy dość przypadkowo odkryliśmy w laboratorium efekt PEPS, nasze prace nabrały tempa – nie bez satysfakcji przyznaje dr Szaciłowski.

Efekt fotoelektrochemicznego przełączenia fotoprądu (PEPS, od ang. PhotoElectrochemical Photocurrent Switching) definiowany jest jako zmiana kierunku fotoprądu pod wpływem zmiany polaryzacji elektrody i/lub długości fali światła padającego na elektrodę. Mój rozmówca podkreśla, że opisany przez niego i Wojciecha Macyka mechanizm obejmuje zarówno właściwości energetyczne, jak i geometryczne, powierzchniowo modyfikowanych półprzewodników. W przypadku dużego obiektu zmiana jego geometrii nie niesie ze sobą zmian właściwości. Ale już w małym obiekcie zmniejszenie geometrii powoduje efekt uwięzienia kwantowego i niekiedy drastyczną zmianę właściwości. Rozszyfrowanie mechanizmu PEPS trwało blisko trzy lata, ale dodało krakowskim chemikom skrzydeł. Zrozumienie tego efektu – zależności między pewnymi elementami strukturalnymi związków organicznych i możliwością modyfikacji ich właściwości – pozwoliło na dalsze badania.

– Efekt PEPS wydaje się być procesem niezwykle istotnym z punktu widzenia nanoelektroniki, ponieważ pozwala na wykorzystanie zarówno sygnału optycznego, jak i elektrycznego do sterowania kierunkiem generowanego przez układ fotoprądu. Równie istotny jest fakt, że procesy te zachodzą w obrębie jednego materiału .

Podejście zespołu kierowanego przez dr. Konrada Szaciłowskiego jest zresztą unikalne w dwójnasób. Obok wykorzystania opisanego po raz pierwszy efektu PEPS, zasadza się na tym, że nie budują oni, krok po kroku, tak jak to zwykło się czynić, obwodu z poszczególnych elementów. Ich układ nie ma planowanej wewnętrznej struktury. Jest ona chaotyczna, ale tylko na pozór. Bo choć rzeczywiście w skali pojedynczych kryształów kontroli nad nimi nie ma żadnej, to w całym układzie występuje zjawisko samoorganizacji. To podejście na wskroś nowatorskie.

– Na powierzchni jednego centymetra znajdują się setki miliardów nanokryształów, które pracują równolegle. Sygnał elektryczny na poziomie pojedynczego nanokryształu jest zbyt słaby, żeby go zarejestrować prostymi technikami. Obserwujemy więc całość, czyli efekt pracy równoległej wszystkich nanokryształów. Panujemy nad nimi w procesie syntezy. Już na samym początku potrafimy odpowiednio zaprogramować materiał .

„Ugotowali” maszynę

Nie wszystkie zachowania materiałów w skali nano da się łatwo przewidzieć. Większość atomów budujących kryształ znajduje się na jego powierzchni, silnie oddziałując ze sobą. To zasadnicza różnica w porównaniu ze skalą makroskopową, gdy większość atomów jest wewnątrz. Nie oznacza to, bynajmniej, że te pierwsze działają wbrew prawom fizyki.

– W skali nano prawa fizyki są oczywiście zachowane, ale właściwości nanoskopowych materiałów są zwykle zupełnie inne niż w skali makro. Kiedy atomy są nieosłonięte sąsiadami, mają zupełnie inną reaktywność. Poza tym w skali nano znacznie silniej przejawiają się efekty kwantowo-mechaniczne – wyjaśnia dr Szaciłowski, precyzując od razu, że w zasadzie jedynym ograniczeniem w doborze konkretnego związku organicznego jest… wyobraźnia. Podstawą selekcji jest bowiem kryterium doświadczalne. Szuka się więc związków, które oddziałują z powierzchnią w taki sposób, by zachodziła łatwa wymiana ładunku elektrycznego pomiędzy składnikiem organicznym a nieorganicznym. Jeśli takie oddziaływania się nie pojawiają, poszukiwania są kontynuowane. Jak zatem widać, i pół wieku temu, u Feynmana, i dziś intuicja w nauce wciąż odgrywa dużą rolę. I tak jak przepowiednia amerykańskiego fizyka znalazła po latach odzwierciedlenie w rzeczywistości, tak krakowscy naukowcy wykazali, że modyfikowane nanokrystaliczne półprzewodniki szerokopasmowe mogą zostać wykorzystane do budowy zaawansowanych układów optoelektronicznych.

– Dobrze jest wykonać czasem skok na głęboką wodę. Ale bez żmudnej, doświadczalnej pracy wiele zrobić się nie da. Z siarczkiem kadmu męczyliśmy się trzy lata. Z literatury wynikało, że to materiał, z którego nie da się zrobić nic nowatorskiego. Okazało się, że dzięki zastosowaniu nietypowej metody syntezy z użyciem zwykłej kuchenki mikrofalowej otrzymaliśmy materiał o zupełnie innych właściwościach .

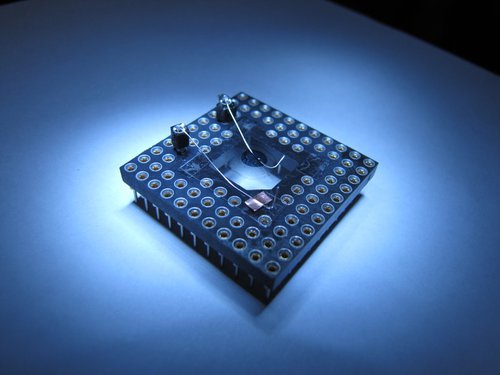

Już na samym początku nanokryształ został odpowiednio zmodyfikowany. Zawiesinę cząstek naniesiono na podłoże przewodzące i przykryto drugą elektrodą. Kilka takich „kanapek” połączono w obwód, na który następnie skierowano sygnały optyczne, będące wejściem układu. Jednocześnie mierzono natężenie, jakie płynęło w obwodzie w momencie pojawienia się błysków światła. Natężenie prądu zależy bowiem od właściwości tych impulsów. Prąd stanowił sygnał wyjściowy. Mając informację początkową i końcową, można było określić, co się dzieje „po drodze”. To był eksperyment przełomowy.

– Zbudowaliśmy tym samym optoelektroniczny sumator. Udowodniliśmy, że w prosty sposób, z użyciem prostych materiałów, przy odpowiednim sterowaniu syntezą, można zbudować, a właściwie „ugotować”, prostą maszynę obliczeniową .

Od tygodnia do trzech lat

Chociaż intensywne badania nad siarczkiem kadmu trwają na świecie już dość długo, to nikt wcześniej nie badał go pod względem wykorzystania do układów przetwarzających informacje. Dla krakowskich naukowców okazał się on bardzo kłopotliwym materiałem. Samo opracowanie oddziaływań na jego powierzchni zajęło blisko trzy lata. Opłacało się, bo właśnie ten związek dał najciekawsze wyniki. Ale eksperymentowano też np. z dwutlenkiem tytanu, który, modyfikowany kompleksami żelaza, zastosowano w konstrukcji nietypowych obwodów liczących, zaś modyfikacja kwasem foliowym pozwoliła na rozróżnianie zasad wchodzących w skład DNA. Konstrukcję i mechanizm działania jednego z układów logicznych zbudowanego na bazie dwutlenku tytanu udało się opracować w… tydzień. Nie ma zatem reguły.

– Natura broni się z odsłonięciem swoich tajemnic, ale przed wytrwałymi i cierpliwymi czasem się odkrywa – filozoficznie podchodzi do sprawy dr Szaciłowski, zwracając przy tym uwagę, że 10 lat temu dysk twardy przeciętnego komputera mógł pomieścić około 4 GB danych, teraz pojemność nośników pamięci może być ponad sto razy większa – a to i tak nie jest jeszcze ostateczna granica. Tę stanowi niepodzielny atom – elementów mniejszych zbudować już się nie da. Nie ma jednak złudzeń co do tego, że elektronika molekularna wyprze klasyczną półprzewodnikową, bazującą na krzemie. Z pewnością mogłaby, gdyby udało się pokonać jeszcze jedną barierę, a mianowicie odprowadzenie ciepła, które generowane jest w ogromnych ilościach przy coraz większym zagęszczeniu elementów w obwodach elektronicznych. Nowe materiały tej konsekwencji miniaturyzacji też nie potrafią obejść. Tym niemniej jest wiele nisz, gdzie mogą być wykorzystane. Jedną z nich jest analityka medyczna.

– Nanoobiekty mogą dokonywać identyfikacji hormonów, enzymów i dawać pacjentowi konkretną odpowiedź na temat stanu zdrowia. Na podobnej zasadzie, jak glukometr u cukrzyków. Takie małe urządzenie przyda się też w nagłych wypadkach lekarzom, którzy w kilka sekund, na podstawie szybkiej analizy krwi, określą, czy nastąpił uraz głowy, jamy brzusznej, czy układu kostnego, a więc będą wiedzieli, którą częścią ciała zająć się w pierwszej kolejności .

Materiały hybrydowe będą mogły też być używane w makroelektronice, np. w wyświetlaczach ciekłokrystalicznych czy inteligentnych ubraniach wyposażonych w matryce sensorów. Wśród takich niszowych zastosowań szczególną uwagę zwraca projekt dotyczący budowy obiektów optoelektronicznych, które będą mogły symulować zachowanie neuronów. Jednym słowem, chodzi o wyprodukowanie syntetycznego neuronu. To dopiero będzie sukces mierzony w skali nano. Czyli o wiele mniejszej niż ćwiartka główki szpilki. ☐

Komentarze

Tylko artykuły z ostatnich 12 miesięcy mogą być komentowane.