Indeksy cytowań i wiosła

Wyniki pracy danego naukowca są dobre, jeżeli tak uważa wielu innych dobrych uczonych pracujących w tej samej dziedzinie. Ta prosta zasada sprawdzała się przez całe stulecia, gdy całkowita liczba ludzi prowadzących badania naukowe była niewielka, a wybitni uczeni mogli dokładnie śledzić postępy i znać szczegółowo wyniki innych naukowców pracujących w danej dziedzinie.

Liczba cytowań oraz indeks H

W ciągu minionego wieku liczba osób uprawiających naukę wzrosła niezmiernie, a specjalizacja zaszła tak daleko, że nikt nie jest w stanie kompetentnie ocenić wyników uczonych pracujących w innej specjalizacji danej dziedziny. Dlatego też z konieczności do wstępnej oceny dorobku badacza stosuje się dane bibliometryczne: całkowitą liczbę opublikowanych prac, liczbę cytowań czy indeks H, który wynosi N, jeżeli spośród wszystkich prac danego autora N z nich zostało zacytowanych co najmniej N razy.

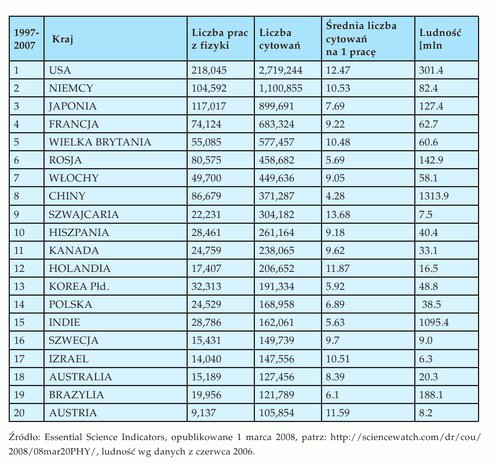

Tabela 1. Liczba prac i cytowań z dziedziny fizyki z okresu od stycznia 1997 do końca grudnia 2007

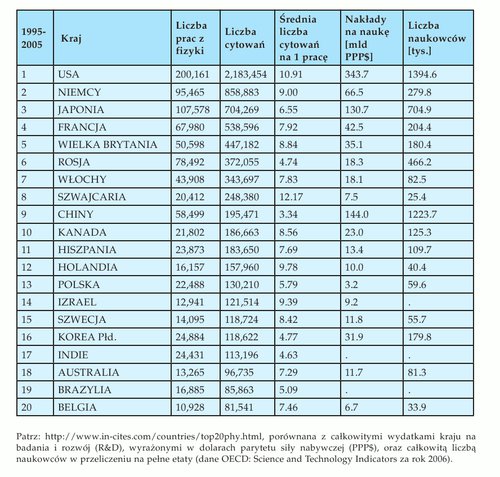

Tabela 2. Liczba prac i cytowań z dziedziny fizyki z okresu od stycznia 1995 do 30 kwietnia 2005

Na przykład, jeżeli indeksy H dwóch kandydatów na stanowisko profesora wynoszą odpowiednio 17 i 7, to istnieje silna poszlaka, iż dorobek pierwszego z nich jest poważniejszy. Oczywiście ostateczną odpowiedź na to pytanie mogą dać dopiero eksperci, którzy zaznajomili się szczegółowo z publikacjami obu kandydatów. Jakiekolwiek bezpośrednie porównanie danych bibliometrycznych ma sens wyłącznie w przypadku osób pracujących w tej samej dziedzinie nauki, gdyż każda gałąź wiedzy ma swoją specyfikę.

Polska fizyka i jej pozycja w świecie

Gdy w roku 1979 rozpoczynałem studia fizyczne w Uniwersytecie Jagiellońskim, byłem przekonany o potędze fizyki polskiej. Na tle siermiężnej rzeczywistości realnego socjalizmu korzystnie wyróżniali się fizycy, którzy mieli możliwość przez pewien czas pracować w najlepszych ośrodkach naukowych Europy Zachodniej i Ameryki. Dzięki doświadczeniom zdobywanym za granicą uczeni ci mogli w Polsce prowadzić badania na konkurencyjnym poziomie i utrzymywać kontakty z wiodącymi grupami badawczymi na całym świecie. Podobne osiągnięcia odnosili też nieliczni przedstawiciele innych nauk przyrodniczych, co sprawiało, że wypadkowa pozycja Polski na mapie naukowej świata wyglądała na relatywnie dobrą. Ponieważ nie używano wówczas powszechnie danych bibliometrycznych, tej optymistycznej tezy nie można było łatwo potwierdzić.

Od tego czasu w naszym kraju zmieniło się niemal wszystko, poza sposobem organizacji nauki. Podobnie jak za dawnych lat płace pracowników nauki są słabo powiązane z efektami ich pracy, a obowiązujący system nie wymusza prowadzenia badań na wysokim poziomie. Chociaż nieliczni polscy naukowcy potrafią w praktyce udowodnić, że także w naszym kraju da się obecnie uzyskiwać znaczące rezultaty, spora część środowiska zadowala się działalnością pozorną. Ponieważ badania w innych krajach nie stoją w miejscu, pozycja naukowa Polski w świecie spada.

Niestety, ta tendencja dotyczy także polskiej fizyki, co nieubłaganie wykazują dane bibliometryczne. Jak pokazuje porównanie tabel 1 i 2, pod względem całkowitej liczby cytowań w dziedzinie fizyki Polska została wyprzedzona przez Koreę Południową i od roku 2005 spadła z 13. na 14. miejsce. O ile polska chemia i matematyka utrzymują się nadal w drugiej dziesiątce, to odległe miejsca przedstawicieli nauk biologicznych, medycznych, technicznych i społecznych sprawiają, że w miarodajnej kategorii całkowitej liczby cytowań zajmujemy obecnie dopiero 25. miejsce na świecie.

Analiza powyższych danych, dostępnych na stronach internetowych firmy Thomson Scientific, pokazuje, iż w Rosji, w państwach Europy Środkowej i w krajach azjatyckich przeważa publikowanie dużej liczby mniej wartościowych prac, które później rzadko są cytowane. Mogłoby się wydawać, iż pod tym względem polska fizyka poprawiła się w sposób znaczący, gdyż średnia liczba cytowań na pracę opublikowaną przez polskiego fizyka wzrosła z 5,8 do 6,9. Jest to jednak ogólny efekt związany z upływem czasu – każda opublikowana praca została średnio więcej razy zacytowana, a więc dla każdego kraju ten wskaźnik wzrasta.

Zauważmy, że typowa publikacja fizyka ze Szwajcarii jest cytowana prawie dwukrotnie częściej niż jego kolegi z Polski. Liczby te ciekawie jest porównać ze wskaźnikami opisującymi najlepsze ośrodki badawcze na świecie. I tak praca fizyka z Harvardu cytowana jest średnio 20,6 razy, podczas gdy dla innych znanych ośrodków liczby te wynoszą: Princeton University – 19.0, MIT – 17,9, CERN – 16,6, Los Alamos National Lab – 13,5, University of Cambridge – 13,1, Max Planck Society (Niemcy) – 12,6, INFN (Włochy) – 10,7, Uniwersytet w Tokio – 10,6, CNRS (Francja) – 7,6. Dane te świadczą też o przewadze, jaką daje ośrodkom w krajach anglosaskich dominacja języka angielskiego i zgodne są z powszechną obserwacją, iż uczeni amerykańscy najchętniej cytują prace amerykańskie. Na tym tle nieźle prezentują się polskie prace z szybko rozwijających się dziedzin fizyki, których wskaźnik cytowania na pracę (nadciekłość – 7,9, kondensat Bosego−Einsteina – 7,6) przekracza średnią krajową.

Warto podkreślić, że dane w tabelach są ekstensywne, czyli pokazują zsumowany dorobek poszczególnych państw. Jeżeli, biorąc pod uwagę ludność każdego kraju (patrz: tabela 1), policzymy wskaźniki intensywne, to Polska zyska w stosunku do Chin oraz Rosji, ale znajdzie się daleko w tyle nie tylko za Szwajcarią i Holandią, lecz także za Izraelem, Szwecją oraz Belgią.

Z drugiej strony, nakłady Polski na badania są niezmiernie małe: Polska przeznacza na te cele około 0.5 proc. produktu krajowego brutto, podczas gdy wskaźnik ten w Szwecji i Finlandii przekracza 3 proc., a średnia EU−27 wynosi 1.8 proc. W tabeli 2 umieszczono całkowite wydatki na badania danego kraju wyrażone w dolarach siły nabywczej. Biorąc pod uwagę poniesione wydatki, wyniki polskiej nauki są niezłe – umiemy publikować cytowane prace naukowe przy stosunkowo małych kosztach. Jednakże tym wskaźnikiem nie za bardzo wypada się chwalić, gdyż relatywnie małe całkowite koszty opublikowania jednej pracy w porównaniu do krajów Zachodu są po części konsekwencją niekonkurencyjnych zarobków w nauce polskiej.

Porażka w konkursie o granty ERC

Niezależnie od danych bibliometrycznych problemy nauki polskiej dobrze ilustrują wyniki w konkursach o granty prowadzonych przez European Research Council. W ramach 7. Programu Ramowego zorganizowano w roku 2007 konkurs o Starting Independent Researcher Grants (StG) dla młodych badaczy (od 2 do 9 lat po doktoracie). Spośród 9167 wniosków młodych naukowców z Europy międzynarodowy panel ekspertów wybrał 559 najlepszych projektów do realizacji w 21 krajach europejskich. W gronie zwycięskich projektów badawczych nie znalazł się ani jeden, który planowano realizować w Polsce, a fakt ten nagłośnił artykuł Cezarego Wójcika – szefa rady Niezależnego Forum Akademickiego (Młodzi naukowcy z Polski nie dostaną pieniędzy z UE, „Gazeta Wyborcza”, 27.11.2007).

Wyników tych nie należy interpretować jako rezultatów antypolskiego spisku ekspertów z całej Europy. Jak pisał ostatnio uczestnik zespołu ekspertów oceniających wnioski, prof. Adam Łomnicki (Liderzy i maruderzy, „Forum Akademickie”, nr 2/2008; patrz też: http:// www.eko.uj. edu.pl/ lomnicki/panel−erc.pdf) w ocenie wniosków kierowano się wyłącznie kryteriami merytorycznymi. Wniosków z Polski nie było wiele i niestety były one istotnie słabsze od najlepszych wniosków z Europy Zachodniej. Na końcowy wynik składała się zarówno ocena dotychczasowego dorobku naukowego kandydata, jak i proponowanego projektu badawczego.

Każdy wnioskodawca z listy swych publikacji za okres ostatnich 5 lat musiał wybrać 5 najlepszych prac, podając przy każdej z nich, ile razy była już cytowana w literaturze światowej (bez uwzględniania autocytowań). Dorobek każdego kandydata był niezależnie oceniany przez co najmniej 4 ekspertów, a średnia tych ocen dała podstawę do wstępnego rankingu złożonych wniosków. W kolejnej fazie prac panelu eksperci dyskutowali szczegółowo jedynie wnioski z górnej połowy tak przygotowanej listy. Niestety, wszystkie wnioski z Polski (oraz znaczna większość wniosków pochodzących z nowych krajów Unii) znalazła się w tej dolnej, odrzuconej połowie listy. Przy dużej liczbie składanych wniosków dane bibliometryczne mogą być pomocne do wstępnej selekcji kandydatów. Wniosek autora z mniejszą liczbą cytowań niż mediana całej grupy wnioskodawców nie miał praktycznie szans na przejście do następnego etapu konkursu.

Obecnie trwa kolejny konkurs ERC o Advanced Investigator Grant, o które może się starać każdy uczony europejski. Przedstawiając swój dorobek, wnioskodawca musi wybrać 10 swoich najlepszych publikacji z okresu ostatnich 10 lat i przy każdej z nich podać liczbę cytowań. Ponieważ gra idzie o wielkie pieniądze (granty wynoszą do 3,5 mln euro na okres 5 lat), można się spodziewać znacznej konkurencji ze strony najlepszych badaczy z całej Europy. Termin składania wniosków upłynął z końcem kwietnia br., a wyniki konkursu znane będą w listopadzie 2008. Jesienią zobaczymy, czy w gronie zwycięzców konkursu znajdzie się tym razem choć jeden uczony pracujący w Polsce (K. Życzkowski, Naukowe starszaki, do roboty!, „Gazeta Wyborcza”, 9.01.2008.).

Niezbędne reformy

W ciągu ostatnich lat liczni autorzy publikowali teksty wskazując konieczność zmian systemu organizacji nauki w Polsce. Obecnie mogą z zadowoleniem przyjąć deklarację rządu o planach przeprowadzenia reformy nauki i szkolnictwa wyższego oraz cieszyć się ożywioną debatą prowadzoną na ten temat w mediach. Jednakże szkoda, że ta dyskusja została praktycznie zdominowana przez problem habilitacji. Jest to, moim zdaniem, temat zastępczy. Zasadniczym celem reformy winno być stworzenie mechanizmów powodujących, by nauka polska stała się konkurencyjna w skali Europy. Niezależnie od tego, czy habilitacja w Polsce zostanie zniesiona, czy też zmodyfikowana, polscy naukowcy muszą być silniej zmotywowani do dobrej pracy, a proces zatrudniania profesorów w uczelniach musi gwarantować rzetelną i obiektywną ocenę ich dorobku naukowego. Osoby niezainteresowane uczestnictwem w rozwoju nauki światowej powinny sukcesywnie odchodzić od pracy w nauce. Naukowcom, którzy zdecydują się kontynuować badania, należy więcej płacić, ale też znacznie więcej od nich wymagać.

Łatwiej się zgodzić z powyższymi założeniami niż zaproponować i zrealizować spójny program szczegółowych kroków, służących do podniesienia konkurencyjności nauki polskiej. Miejmy nadzieję, że pani minister Kudrycka weźmie pod uwagę różne głosy w tej sprawie pochodzące ze środowiska uczonych polskich w kraju (List otwarty Wydziału Fizyki, Astronomii i Informatyki Stosowanej UJ, http://www.fais.uj.edu.pl/list/) i za granicą (Apel Niezależnego Forum Akademickiego do Premiera RP w sprawie kontynuowania reformy nauki i szkolnictwa wyższego, http:// www.nfa.pl/), aby wybrać optymalny wariant zmian systemu. Rezultaty przeprowadzonej reformy będą widoczne dopiero w skali kilku lat. W dalszej części tego artykułu skoncentruję się na znacznie węższym zagadnieniu: Co można zrobić, aby wyniki kolejnych konkursów European Science Council były choć trochę korzystniejsze dla Polski?

Metoda kija i marchewki

W niektórych krajach Europy Zachodniej funkcjonują systemy dodatkowej motywacji uczonych do przygotowywania podań o granty ERC. Francja, Włochy i Hiszpania jako zachętę oferują bardzo soczystą marchewkę: każdy wniosek o grant, który przejdzie do II etapu konkursu, a nie zostanie ostatecznie zakwalifikowany do finansowania przez ERC, otrzyma automatycznie „grant pocieszenia”, finansowany przez ministerstwo nauki w danym kraju. Wydaje się, że podobny sposób może być bez przeszkód stosowany w Polsce. Granty Advanced Investigator to średnio dofinansowanie prac zespołu badawczego sumą rzędu 2 mln euro. Gdyby w Polsce oferować jedynie dziesiątą część tej dużej sumy, to i tak mobilizowałoby to uczonych do składania wniosków w ERC. A biorąc pod uwagę dotychczasowe rezultaty konkursów europejskich, obciążenie budżetu polskiego ministerstwa nie byłoby znaczne.

Porównując liczby wniosków składanych do ERC z liczbą przyznanych grantów, można zobaczyć, że szansa otrzymania grantu nie jest duża. Ale prawdopodobieństwo sukcesu zwiększy się znacznie, jeżeli wnioski z Polski będą pisane jedynie przez kandydatów z odpowiednim dorobkiem na poziomie europejskim. Jak zatem kierujący polską nauką mogą zidentyfikować uczonych z realnymi szansami na sukces? Przecież urzędnicy ministerstwa nie są w stanie sami regularnie prowadzić analizy osiągnięć uczonych. Można natomiast bez przeszkód skorzystać z metody wstępnej oceny dorobku naukowego za pomocą tych samych metod bibliometrycznych, które stosowane są w ERC do oceny wniosków o granty. Przekazując szkołom wyższym i instytutom badawczym dotacje na działalność, ministerstwo nauki może na przykład wymagać przygotowywania takich danych.

Nie wydaje się celowe, aby każdy pracownik nauki w Polsce przesyłał do Brukseli wnioski o dofinansowanie programów badawczych. Ale każdy może, a wręcz powinien przymierzać się do tego wyzwania. Jak to uczynić? Po prostu corocznie stosować bibliometryczne kryteria ERC do samooceny swego dorobku naukowego.

Okienka prawdy

Minister nauki może zobowiązać dyrektorów instytutów badawczych oraz rektorów uczelni państwowych, aby ci wymusili na swych pracownikach coroczne przygotowywanie listy publikacji według standardu ERC i wywieszanie jej przy każdym nazwisku zatrudnionego na otwartej stronie internetowej placówki. Na przykład do końca lutego każdego roku wszyscy zatrudnieni pracownicy naukowi po doktoracie musieliby wybrać 5 swoich najlepszych publikacji z okresu minionych 5 lat i przy każdej podać liczbę cytowań. Samodzielni pracownicy po habilitacji wybieraliby po 10 prac z okresu 10 minionych lat, zgodnie z formułą stosowaną przy ocenie Advanced Grants. Wyboru publikacji powinien dokonać każdy uczony osobiście, gdyż tylko on jest w stanie wybrać te prace, które najlepiej prezentują jego dorobek i zostały zauważone w literaturze przedmiotu.

Zauważmy, że metoda oceny dorobku stosowana przez ERC nie wymaga podawania całego spisu publikacji ani też badania współczynników impact factor, których z powodzeniem używa się do oceny jakości czasopisma naukowego oraz do predykcji liczby cytowań, jakie dana publikacja osiągnie w przyszłości. W ocenie uzyskanego w ciągu mijającej dekady dorobku poszczególnego badacza bardziej miarodajne są liczby już uzyskanych cytowań niż współczynniki impact factor, które jedynie charakteryzują prawdopodobieństwo zauważenia pracy w literaturze światowej.

Wyobraźmy sobie, że w witrynie internetowej każdego wydziału czy instytutu naukowego istniejącego w Polsce, przy spisie zatrudnionych naukowców obowiązkowo pojawiają się „okienka prawdy”, w których każdy pracownik corocznie uzupełnia dane świadczące o jego dokonaniach: podaje jedynie wybranych 5 (adiunkt) lub 10 (profesor) najlepszych publikacji z okresu ostatnich 5 (10) lat wraz z liczbą cytowań.

System ten, z jednej strony, ułatwi ministerstwu określenie grupy uczonych, którzy w ogóle mogą mieć szansę w konkursach europejskich. Z drugiej strony, tak przygotowane dane w zupełności wystarczą kierownictwu jednostki do oceny działalności naukowej jej pracowników, co umożliwi porzucenie bardziej uciążliwej sprawozdawczości. Ponadto ujawnienie wyników corocznej samooceny pracowników naukowych będzie miało walory motywacyjne: dobrych naukowców zmobilizuje do jeszcze lepszej pracy i pogoni za najlepszymi w Europie, a gorszych skłoni do rozważenia możliwości zmiany miejsca pracy.

Galernicy i wioślarze

Niewolnicy rozpędzający wiosłami starożytne galery nie mieli specjalnej motywacji do dobrej pracy. Słabsze wiosłowanie jednego galernika nie wpływało w widoczny sposób na prędkość statku i mogło być łatwe do ukrycia. Dlatego też niewolnicy na łodzi byli pilnowani przez nadzorców, których zadanie polegało wyłącznie na kontroli pracy wiosłujących, często za pomocą brutalnych środków. Nietrudno zgodzić się z tezą, że w celu uzyskania maksymalnej mocy napędu nie był to idealny system motywacyjny.

Wioślarze uczestniczący w regatach łodzi sportowych mają zupełnie inną motywację do ciężkiej pracy. Nowoczesna, lekka łódź wiosłowa pozwala łatwo wykryć, czy wszyscy członkowie danej osady równo wiosłują. Swoją rolę odgrywa oczywiście trener, ale podczas samych regat zawodnikom nie jest potrzebny nadzorca zmuszający do wysiłku. Gdyby podczas słynnych regat ósemek po Tamizie jeden z członków załogi Oxfordu lub Cambridge zaczął markować wiosłowanie, jego koledzy z drużyny wnet by to zauważyli i skutecznie zachęcili do pracy, a później trener nie powołałby go do reprezentacji uczelni na następne zawody.

Reforma nauki polskiej musi znacząco zwiększyć motywację naukowców do dobrej pracy. Najlepsi muszą więcej zarabiać, ale też trzeba dużo od nich wymagać. Wprowadzenie systemu corocznie aktualizowanych w Internecie „okienek prawdy”, ilustrujących dorobek pracownika nauki opłacanego z pieniędzy podatnika, zwiększy wzajemną motywację badaczy do pracy naukowej. Polskie uczelnie będą miały szansę stać się konkurencyjne wobec uczelni europejskich jedynie w przypadku sukcesu planowanej reformy nauki. Dziekanowi każdego wydziału można tylko życzyć, aby w przyszłości dowodził nie ciężką, nieruchawą galerą z pracownikami o motywacji do pracy zbliżonej do motywacji antycznych galerników, lecz flotyllą szybkich łodzi wiosłowych z osadami wytrenowanych i zmotywowanych zawodników, zawsze gotowych do regat, także z osadami Oxfordu i Cambridge.

Komentarze

Tylko artykuły z ostatnich 12 miesięcy mogą być komentowane.